Archives

Hack voiture : OBD2, erreur dans la gestion d’erreur

Les plus beaux bugs sont des bugs de conception architecturale ou protocolaire (par définition impossibles à corriger sans devoir remettre à plat tout un projet). Parmi ceux-ci règne une aristocratie du défaut de conception : la faille de sécurité provoquée par un mécanisme de sécurité, sorte de « crème à la crème » de l’instabilité binaire.

C’est, tend à prouver un groupe de chercheurs Canadiano-Nippo-Italiens, ce qui frappe la quasi-totalité des automobiles commercialisées depuis plus de 17 ans et qui possèdent toutes une prise de diagnostic elle-même branchée sur un bus CAN (Controller Area Network) chargé de relier capteurs et actuateurs à l’ordinateur de bord.

Cette étude est le fruit d’un travail commun réunissant Polytechnique Milan et deux éditeurs, Linklayer lab et Trend Micro. De manière lapidaire, les chercheurs se sont rendus compte que des messages d’erreur mal formatés et envoyés de manière répétitive par les capteurs d’une voiture, sont considérés comme une preuve de mauvais fonctionnement et déclenchent, dans certains cas, un ordre d’isolation du périphérique « malade ». Isolation qui correspond à un blocage pur et simple de la fonction. Problème bénin s’il s’agit d’un témoin d’ampoule, légèrement plus préoccupant si l’erreur provient d’un élément de freinage ou de direction.

De là à imaginer les scénarii d’injection d’attaque en déni de service, il n’y a que l’épaisseur d’un tournevis et d’un fer à souder : N’importe où sur le bus, par le truchement d’un « faux périphérique » branché soit sur le port OBD (On Board Diagnostic), soit sur le bus de manière directe (un microcontrôleur possédant un firmware spécifique), soit sur le bus mais pouvant être contrôlé à distance. Les options sont nombreuses et le vecteur d’attaque « multiplateforme » par définition.

Dans tous les cas, une telle compromission nécessite un « accès direct à la console » à quatre roues ou au réseau… Ce genre d’intrusion s’appelle généralement « révision des 5000 » et personne ne vient vérifier les certifications des mécanos chargés de l’intervention. Parfois même, le port OBD se situe non pas dans l’habitacle mais sous le capot moteur, dont le système de fermeture est loin d’égaler la porte d’un coffre-fort. Ce qui permet à certains de nos confrères de titrer « Un bug létal qui affecte l’industrie automobile toute entière ». Probablement un oxymore au troisième degré.

Comment atténuer un tel risque ? en repensant le protocole de gestion d’erreur, donc en considérant la quasi-totalité des véhicules en services comme une génération sacrifiée. En supprimant éventuellement certaines fonctions d’isolation/blocage des périphériques « sensibles » comme cela était le cas sur les anciens bus VAN, plus lents mais considérablement plus souples. En attendant l’avènement d’un futur OBD3, les possesseurs de 2CV, Jeep Willis et fardiers de Cugnot vont faire figure d’experts en matière de sécurité automobile.

Juridique : Quand l’A.V. maria Kaspersky et Microsoft

Chez Kaspersky, c’est une victoire par repli de l’adversaire, pour Microsoft, il s’agit là d’une « évolution stratégique »… une victoire également mais à la Pyrrhus, en Français une « défense élastique » . Car après un triple dépôt de plainte de Kaspersky auprès des tribunaux Européens, Allemands et Russes chargés de réglementer la libre concurrence commerciale, la Windows Company a promis de « mieux partager les informations liées aux mises à jour de Windows 10 ». Des changements en matière de compatibilité avec des produits de sécurité tiers devant notamment voir le jour avec la prochaine Windows 10 Fall Creators Update.

« Nous travaillerons mieux avec les vendeurs d’antivirus, nous leur offrirons une meilleure visibilité sur les versions à venir, nous leur permettrons de générer leurs propres alertes de mise à jour bien avant leur date d’expiration et modifierons la manière dont Windows informera les usagers quant à leur protection antivirus » explique en substance le billet de blog de Rob Lefferts, le « Partner Director » de la branche Windows Enterprise and Security. Pour combien de temps ?

Bienvenue aux Gattaca virus

Forger le vivant pour mieux tuer la machine : une équipe de chercheurs de l’Université de Washington est parvenu à « faire les grands titres » de la revue du MIT, de Wired, de Boing Boing et de TechCrunch. Quatre confrères qui titrent « Comment infecter un ordinateur avec une chaîne d’ADN ».

L’ennui, c’est que le rapport des chercheurs ne raconte pas exactement la même histoire. Ces Universitaires ont en fait profité des faiblesses d’un système d’analyse et de séquençage en lui injectant la représentation numérique d’une chaîne d’acide nucléique et non la chaîne elle-même. Forger un véritable ADN aurait nécessité des moyens considérablement plus conséquents, et les résultats auraient été encore plus aléatoires… dans la vraie vie, le biohacking façon Jurassique Park appartient encore au domaine de la science-fiction.

Entre également en jeu la façon dont le logiciel de séquençage « saucissonne » la représentation de la chaîne d’ADN dans le but d’accélérer l’analyse en faisant appel à des opérations fortement parallélisées. Ce qui, expliquent les chercheurs, oblige l’auteur de l’exploit non seulement à inventer des séquences génétiques hautement improbables, donc susceptibles d’être rejetées, mais encore à faire tenir son PoC dans la taille de l’échantillon en question. Et même dans ces conditions, le taux de succès frise à peine les 37% sur un type très particulier de logiciel d’analyse. Pour un exploit de type « avec accès direct à la console », c’est peu, très peu.

La compromission consiste en un premier temps à provoquer un débordement de tampon, et d’injecter ensuite une séquence exécutable en mémoire. Un déroulement assez classique dans le cadre d’attaques par fourniture de données forgées.

Comme le domaine médical semble plaire à la presse, il serait ainsi possible de décliner cette méthode avec une injection de faux rhésus de sang d’alien, un buffer overflow via une cytobactériologie urinaire d’hirondelle d’Afrique (ou d’Asie), ou un « man in the middle » initialisé par une coproculture de mammouth trafiquée. Voilà pour la partie fantasmatique. En revanche, imaginons un bruit électromagnétique (donc un signal apparemment aléatoire et naturel parfaitement maîtrisable et simple à forger, reçu par n’importe quel poste de radio logicielle). Là, l’exploit est considérablement plus réaliste, car il n’est lié à aucune contrainte biologique.

DigiCert achète l’activité Certificats de Symantec

C’est décidé, DigiCert est acquéreur de l’activité « certification » de Symantec. Le montant annoncé de la transaction s’élève à 950 millions de dollars. Symantec conservera 30 % des parts (minorité non bloquante) de la nouvelle entité.

Aux termes de cet accord, DigiCert récupèrera toute l’activité de Symantec CA, autrement dit l’infrastructure (informatique, organisationnelle, entreprise), le personnel et les « racines ». Les certificats émis relèveront de l’autorité du repreneur à partir de décembre de cette année.

Asimov : le Robot qui mentait à l’oreille des hommes

De toute manière, on ne peut pas faire confiance à un robot … certains sont même conçus spécifiquement pour tromper l’homme nous apprend la très sérieuse MIT Technology Review. Un article qui met en évidence le « rôle majeur des robots dans la diffusion des fausses nouvelles ». L’on parle ici de « Bots » sur les réseaux sociaux tels que Twitter.

Pour parvenir à de telles constatations, des chercheurs de l’Université d’Indiana ont épluchés, durant la précédente campagne présidentielle US, près de 122 sites d’information réputés pour diffuser ces « fake news ». Des sites satiriques ou partisans tels que infowars, breitbart, politicususa, ou theonion. La somme de travail est pharaonique : 400 000 affirmations ou révélations, ayant engendré 14 millions de messages Twitter. Le tout contrebalancé par quelques 15 000 articles de contre-feu émis par les médias spécialisés dans le « fact checking ». Et de conclure que les robots sont efficaces, particulièrement en matière de transmission. Car, dans ce monde d’instantanéité émotionnelle que sont les réseaux sociaux, il suffit qu’une histoire croustillante soit rapportée par un compte automatique pour qu’ensuite de véritables humains s’empressent de le retwitter, sans la moindre vérification. Le robot agit donc en utilisant des ressorts psychologiques simples mais excessivement toxiques.

L’Université d’Indiana met à disposition du public deux outils ayant servi à la rédaction du mémoire : Botometer, un détecteur de Bot, et Hoaxy, instrument d’évaluation des mécanismes de diffusion de fausses nouvelles.

Asimov, il est où, le JTAG ?

L’homme doit pouvoir garder le contrôle et devrait être capable de corriger les défauts des robots à tout instant. C’est ce que demande en substance une proposition de loi US (faudra-t-il 4 ans pour que les Européens s’en inspirent ?) déposée par des Sénateurs tant démocrates que républicains. Un texte qui vise essentiellement l’Internet des Objets, lesquels « devront être capables de se voir appliquer des correctifs, ne comporteront aucun mot de passe « codé en dur » et seront exempts de défauts de sécurité connus et déjà référencés » précise Mark Warner, l’un des élus à l’origine de ce projet. Difficile de savoir ce qu’il y a de plus improbable autour de ce texte : un appareil qui respecterait a minima un «Owasp » de la robotique ou une méthode de développement intégrant la sécurité dès la conception du produit.

Etude : Asimov, t’es pas marrant quand t’as bu…

Les trois lois de la robotique sont totalement inapplicables, et le public, inconsciemment, en sait quelque chose. Conséquence probable des charrettes massives des industriels du « brick and mortar » après les plans d’automatisation et robotisation massives. Sans surprise, les clients des compagnies aériennes ne veulent pas entendre parler d’un aéronef totalement autonome, quand bien même le prix du billet diminuerait. La peur du hacker « noir » qui détournerait un long courrier, celle de la panne toujours possible en plein vol, ou l’extrapolation des quelques déboires que connaissent les premières voitures sans chauffeur… Pour les géants de la finance (il s’agit là d’une étude UBS) l’élimination du pilote rapporterait tout de même près de 35 milliards de dollars aux compagnies aériennes, rapporte le magazine Fortune. 31 milliards de rognés sur les charges salariales, 3 milliards de formations devenues inutiles, 1 milliard en économie de carburant. Mais sur 8000 passagers interrogés, 54 % refusent de se demander s’il y a, ou non, un pilote dans l’avion. Quand bien même, rappelle l’article, une majorité d’appareils peuvent dès aujourd’hui atterrir automatiquement, le commandant de bord limitant alors son travail à l’activation des inverseurs de poussée et la conduite de l’appareil sur le taxiway.

En Bref …

NSA : n. fem. : seul groupe de pirates (voir BlackHat) capable de déposer un brevet pour chacun de ses malwares . Nul ne connaît la réaction de ses avocats en cas de contrefaçon

Sci-Hub, le Pirate Bay de la pensée scientifique moderne

Tout le landerneau de la recherche connaît ou a entendu parler de Sci-Hub, ce serveur de publications scientifiques gratuites. Depuis 6 ans, ce moteur de recherche donne accès à une quantité impressionnante de travaux universitaires, traditionnellement protégé par quelques éditeurs ayant un monopole sur lesdites publications. Avec le temps, cet impôt (ce racket estiment beaucoup de chercheurs) enrichissait fortement quelques entreprises du secteur privé, tout en appauvrissant le domaine de la recherche en raison du montant exigé des abonnements. Les éditeurs, et principalement l’anglo-néerlandais Elsevier, ont toujours refusé de communiquer le volume exact des communications téléchargées « légalement » sur leurs portails. Il fallait donc, pour apprécier l’importance réelle de Sci-Hub, mesurer au moins le volume de l’offre du moteur de recherche pirate.

C’est à cet inventaire que se sont attelés 5 chercheurs, travail dont la prépublication du journal PeerJ donne un avant-goût précis. Il en ressort que le monopole d’Elsevier est singulièrement grignoté, puisque plus de 97 % de son catalogue est disponible sans bourse délier sur l’un des nombreux dépôts de Sci-hub. Soit au total un peu moins de 70% des articles universitaires, pourcentage qui dépasse les 85% lorsque les travaux en question ont fait l’objet d’une publication dans l’une des revues privées connues. Testé sur toute une année de requêtes émanant de chercheurs, l’étude tend à prouver que plus de 99% des demandes ont été satisfaites (ce qui ne peut être le cas via les serveurs privés).

Pour les rédacteurs de cette étude, ces chiffres indiquent le « commencement de la fin » de ce monopole.

Plusieurs universités, en Allemagne notamment, ont résilié leurs abonnements auprès d’Elsevier. En outre, les « comités de lecture » de ces sociétés de publication ont été à maintes fois pris en délit de copinage, d’incompétence affectant notoirement le prestige et l’image de sérieux desdites publications. Reste que, notamment Outre Atlantique, les bourses et subsides accordés aux départements de recherche ne reposent souvent que sur un seul critère, le nombre de publications « officielles » effectuées par un groupe de chercheurs. Une sélection quantitative plus que qualitative, qui entraîne les chercheurs à publier des travaux spécifiquement formatés pour « passer » le filtre des comités en question. Une suppression de ces fourches caudines aurait pour premier effet une amélioration du niveau qualitatif des mémoires, ainsi qu’une meilleure transmission du savoir entre chercheurs.

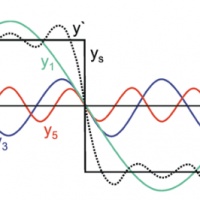

BH 2017 : Mike, dessine-moi une transformée de Fourier

BlackHat2017, Las Vegas : Peut-on transformer une radio logicielle en analyseurs de spectre ? Michael Ossmann et Dominic Spill ont tenté de répondre à cette question en utilisant un vocabulaire d’informaticien. La série de transparents et le texte de la communication effectuée durant la 20ème BlackHat méritent de figurer au panthéon des publications « Spectrum analysis for dummies ».

Car si une radio logicielle affiche bien un spectre et un affichage en chute d’eau couvrant une large portion de l’étendue fréquentielle, on est loin, très loin d’arriver à la cheville d’un véritable analyseur scalaire, avec ses filtres de bande (alias « RBW filters »), sa dynamique, son absence de produits de mélange et artefacts liés à l’imperfection des filtres d’antialiasing des SDR. Et Michael Ossmann d’expliquer comment, malgré ce lourd handicap technique, il est tout de même possible de s’approcher un peu d’une véritable analyse de spectre. Son étude compare différentes interfaces clients, donc gr-fosphor, ShinySDR, QSpectrumAnalyzer associées tantôt à rtl power, tantôt à hackrf sweep (deux méthodes de traitement des transformées de Fourier rapides). Elle explique également comment a dû être ajouté un système de commutation d’antennes capable de couvrir, par tranches successives et sans ralentir le processus de balayage, les quelque 6 GHz de couverture du SDR HackRF. (ndlr : il est parfois plus utile d’utiliser de simples sondes apériodiques, notamment en analyse des rayonnements des champs proches).

Cette approche de l’analyse de spectre « très large bande » s’adresse typiquement aux spécialistes SSI. Les ingénieurs radio, quant à eux, préfèrent travailler sur des spectres plus étroits, avec des filtres de bande excédant rarement la dizaine de kHz et avec une dynamique considérablement plus élevée que ce que permet une radio logicielle 8 bits/20Msps.

L’on pourrait ajouter aux travaux d’Ossmann et Spill qu’un SDR « émission-réception » peut réaliser des mesures en analyse vectorielle (en d’autres termes apprécier la phase d’un signal en plus de son amplitude et de sa fréquence), ce qu’un analyseur scalaire est totalement incapable d’assurer. Avec par exemple VNA du projet OpenHPSDR. Un « plus » qui ouvre notamment la voie aux mesures en réflectométries et aux détections de rupture d’impédance, deux piliers de la défense périmétrique physique.

MORE_POSTS

Archives

| lun | mar | mer | jeu | ven | sam | dim |

|---|---|---|---|---|---|---|

| « Déc | ||||||

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | |||||